WooCommerce-Abos sauber umsetzen, als Lifetime Deal bei AppSumo

Wenn du WooCommerce betreibst, kennst du das Thema: wiederkehrende

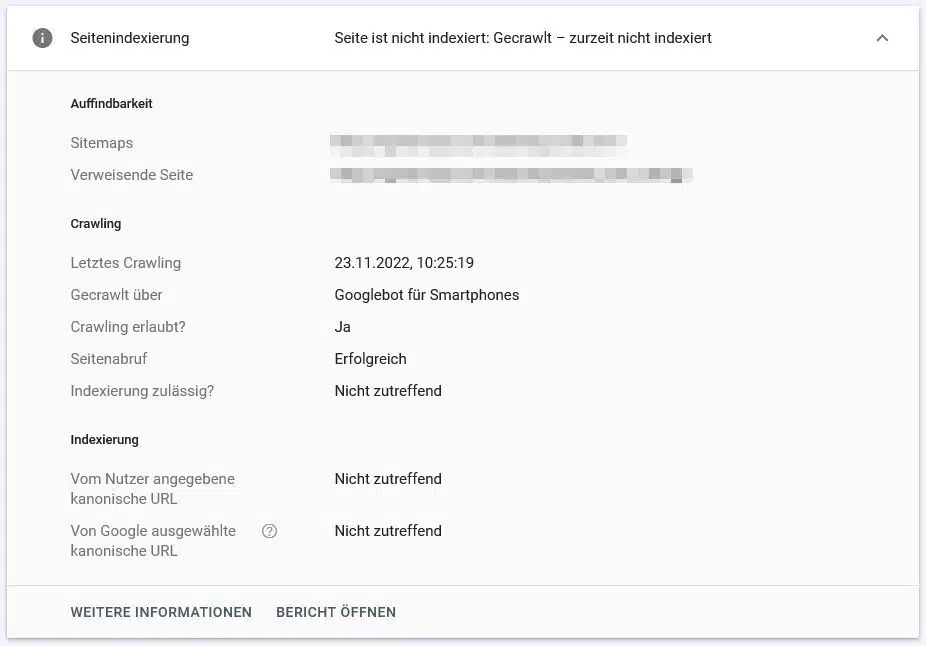

In der Google Webmaster Search Konsole wird unter Gecrawlt – zurzeit nicht indexiert Seiten für eine URL beim Wert „Indexierung zulässig“ das Ergebnis „Nicht zutreffend“ angezeigt. Was bedeutet das?

Inhaltsverzeichnis

ToggleWenn im Google Search Console-Bericht „Indexierung zulässig“ den Wert „Nicht zutreffend“ hat, bedeutet dies, dass die betreffende URL nicht über eine robots.txt-Datei blockiert wird, aber dennoch nicht von der Google-Suchmaschine indexiert wurde. Dies kann auf eine Reihe von Gründen zurückzuführen sein, wie z.B. ein Fehler in der Meta-Robots-Tag oder ein technisches Problem mit der Website, das die Indexierung erschwert.

Es kann auch bedeuten das die Seite gecrawlt wurde aber nicht als wertvoll für die Indexierung befunden wurde. Es empfiehlt sich in solchen Fällen die entsprechende URL überprüfen und die Probleme, falls vorhanden, zu beheben, um die Indexierung zu ermöglichen.

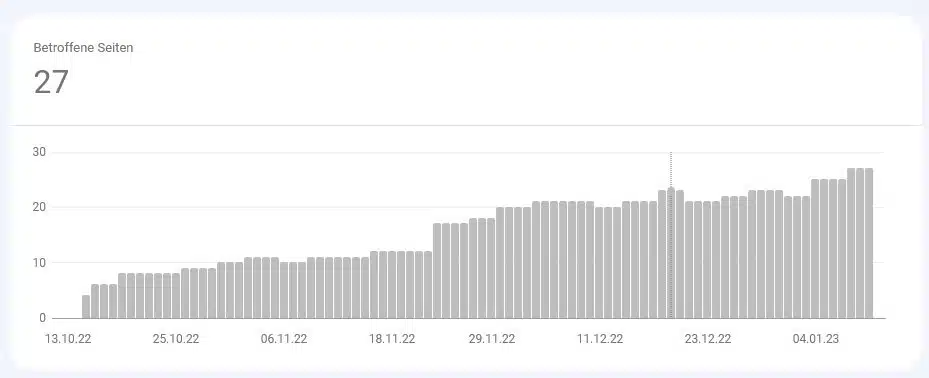

Bericht zur Seitenindexierung

In dem Google Bericht zur Seitenidexierung erfährt Du weitere Details, welche Seiten Google auf Deiner Website finden und indexieren kann und welche Indexierungsprobleme möglicherweise aufgetreten sind.

Welche Probleme können das im genauen sein, die zu dem Ergebnis: Gecrawlt – zurzeit nicht indexiert führen?

Einige der möglichen Probleme, die dazu führen können, dass eine URL nicht von der Google-Suchmaschine indexiert wird, obwohl sie nicht über eine robots.txt-Datei blockiert wird, sind:

Mit welchen Maßnahmen und Analyse Tools lassen sich die verschiedenen Probleme, welche zu dem Ergebnis: Gecrawlt – zurzeit nicht indexiert führen besser eingrenzen?

Um die verschiedenen Probleme, die dazu führen können, dass eine URL nicht von der Google-Suchmaschine indexiert wird, einzugrenzen, können Sie die folgenden Maßnahmen und Analyse-Tools verwenden:

Es ist auch wichtig, die Google Guidelines zu kennen und diese zu befolgen, um sicherzustellen, dass Ihre Webseite für die Suchmaschine optimiert ist und keine grundlegenden Fehler aufweist, die die Indexierung beeinträchtigen können. Es ist wichtig, auf regelmäßiger Basis die Website und seine Konfiguration zu überwachen und die notwendigen Anpassungen vorzunehmen, um eine gute Indexierung durch die Google-Suchmaschine zu ermöglichen.

Eine regelmäßige Überwachung und Analyse der Website ist notwendig, um Probleme frühzeitig zu erkennen und zu beheben, und um sicherzustellen, dass die Website für die Suchmaschine optimiert ist. Auf diese Weise können Sie sicherstellen, dass die Inhalte Ihrer Website leicht von der Google-Suchmaschine gefunden und indexiert werden können, was letztendlich dazu beiträgt, dass Ihre Website für die Nutzer leichter zugänglich ist.

Wenn du WooCommerce betreibst, kennst du das Thema: wiederkehrende

Angetrieben durch evolutionäre Algorithmen optimiert Googles AlphaEvolve autonom Code in beispiellosem Maßstab – aber kann KI, die Software weiterentwickelt, wirklich unabhängig denken?

KI-Agenten von Google verarbeiten gleichzeitig Millionen von Datenpunkten auf eine Weise, die menschliche Kognition nicht kann, was beunruhigende Fragen über unsere zukünftige Relevanz aufwirft.

Wie können KI-Browser funktionieren, wenn ihre Kernintelligenz genau den Datenzugriff und die Autonomie erfordert, die sie grundlegend verwundbar macht?